Il web scraping è un processo di estrazione di dati da siti web in modo automatico. Questo processo può essere utilizzato per diversi scopi, tra cui:

- Raccogliere informazioni da siti web per scopi di ricerca

- Analizzare i dati di mercato per le attività di business

- Creare database di prodotti o servizi

- Monitorare i prezzi

Il web scraping può essere un’utile strumento per le aziende e gli individui che devono raccogliere dati da un gran numero di siti web. Tuttavia, questo processo può anche essere utilizzato per scopi illegali, come il furto di informazioni personali, il copyright infringement o la raccolta di dati da siti web i cui termini di servizio bandiscono questa pratica.

È importante essere consapevoli dei potenziali rischi del web scraping prima di utilizzarlo. Alcuni dei rischi più comuni includono:

- Violazione delle leggi sulla privacy

- Violazione del copyright

- Danni ai siti web

- Blocco dell’accesso ai siti web

È quindi importante utilizzare il web scraping in modo etico e responsabile. Se stai pensando di utilizzare il web scraping, assicurati di leggere e capire le politiche di utilizzo dei siti web da cui desideri estrarre i dati. Assicurati inoltre di utilizzare uno strumento di web scraping affidabile che non danneggi i siti web.

Ecco alcuni suggerimenti per utilizzare il web scraping in modo etico:

- Leggere e capire le politiche di utilizzo dei siti web da cui desideri estrarre i dati.

- Utilizzare uno strumento di web scraping affidabile che non danneggi i siti web.

- Estrarre solo i dati necessari.

- Non estrarre dati da siti web che non sono pubblici.

- Non utilizzare i dati estratti per scopi illegali.

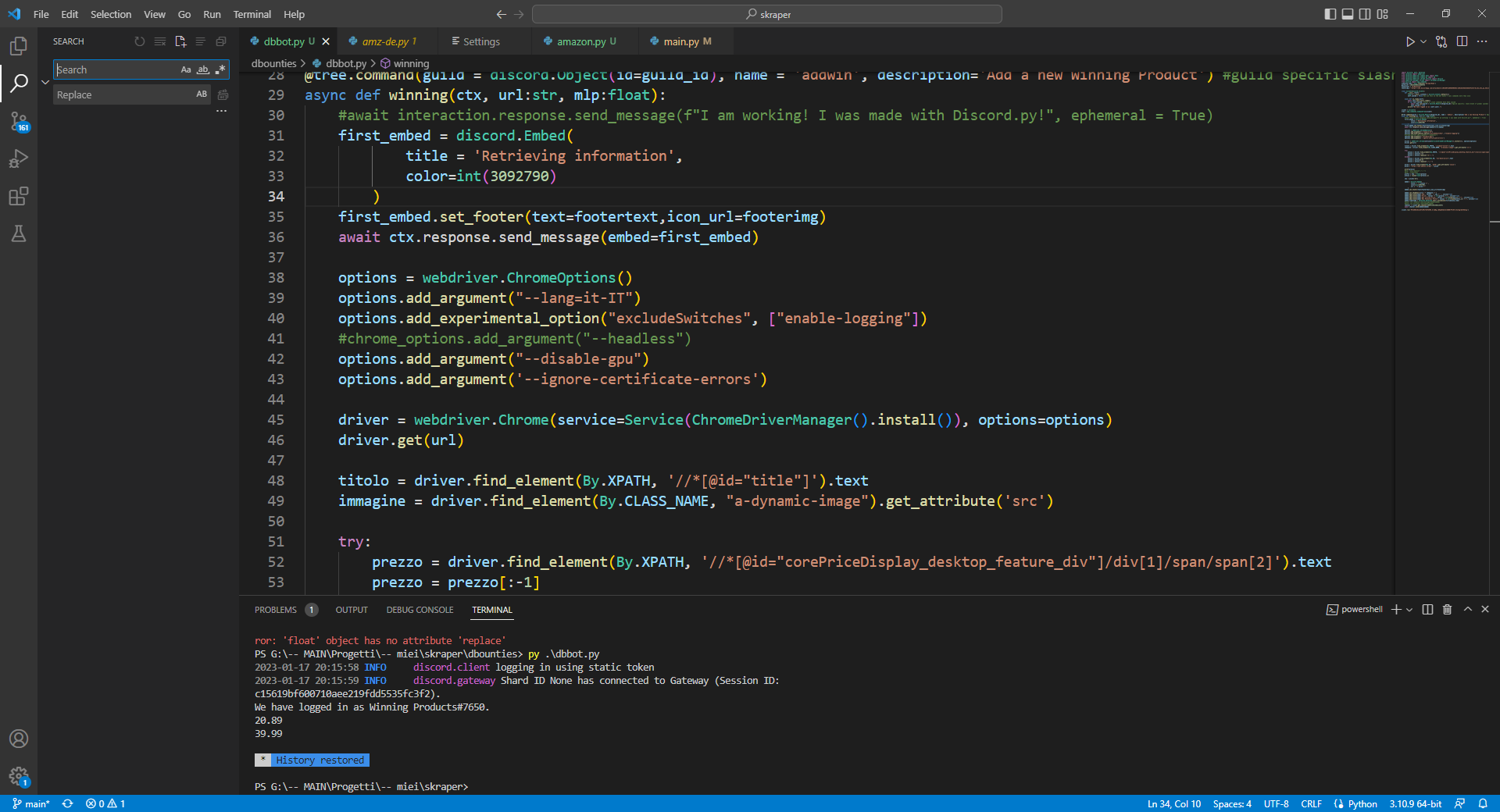

Un caso in cui questa pratica personalmente mi risulta molto utile, è la raccolta di informazioni da un lungo database online.

In questo caso, salvo offline il codice HTML delle pagine che contengono le informazioni di cui necessito, e creo uno script che possa fare scraping da questi file, in modo da non sovraccaricare il server, e magari che mi restituisca l’output già in un file CSV, così che io non debba nemmeno riodinare i dati raccolti.